Jonathan A. Obar, PhD, est professeur agrégé au Département d'études en communication et médias de l'Université York. Ses recherches et son enseignement portent sur les politiques d'information et de communication, et la relation entre les technologies numériques, les libertés civiles et l'inclusivité des cultures publiques. Les publications académiques traitent des mégadonnées et de la confidentialité, des interfaces de consentement en ligne, de la transparence de la confidentialité des données d'entreprise et de l'activisme numérique.

Les ensembles de données pour la formation à l'intelligence artificielle (IA) peuvent être remplis d'informations obtenues sans consentement valable. Qu'une organisation collecte des données directement auprès des utilisateurs ou auprès d'une autre organisation, il est essentiel de s'assurer du consentement valable des personnes représentées dans les données. Alors que le gouvernement canadien débat du projet de loi C-27 et remet en question l'avenir de l'IA éthique, cette question doit être une priorité.

Les développeurs peuvent tenter de former des systèmes d'IA pour aider un magasin à vendre des produits, une banque pour déterminer les hypothèques, une compagnie d'assurance pour coter les primes, la police pour identifier les suspects ou un juge pour calculer les taux de récidive. Dans tous ces cas - et bien d'autres - si les personnes dont les données alimentent ces systèmes n'ont pas consenti à ce que leurs données soient utilisées dans le développement de l'IA, il s'agit d'une violation potentielle des libertés civiles. De plus, le manque de surveillance associé à un manque de consentement significatif pourrait entraîner des préjudices associés à grande discrimination des données.

Écrivant sur la collecte et l'utilisation problématiques de données par les développeurs d'IA, Kate Crawford, une éminente spécialiste de l'IA, met en garde:

L'industrie de l'IA a favorisé une sorte de pragmatisme impitoyable, avec un minimum de contexte, de prudence ou de pratiques de données axées sur le consentement, tout en promouvant l'idée que la collecte massive de données est nécessaire et justifiée pour créer des systèmes d'"intelligence" informatique rentable (p. 95 ).

Quand quelqu'un partage une photo en ligne, convient-il que la photo peut former l'IA pour les ressources humaines ? Lorsque les gens ouvrent la porte d'un centre commercial, conviennent-ils que les images des caméras de surveillance peuvent entraîner une prise de décision automatisée pour les systèmes de justice pénale ? Déplacement des données d'un contexte à l'autre soulève des inquiétudes quant au rôle du consentement en tant que mécanisme de surveillance. Les personnes qui tentent de donner leur consentement après avoir téléchargé une application comprennent-elles comment les informations personnelles peuvent circuler au sein d'une organisation ? Par exemple, à partir du Programme PC Optimum Loblaws aux sociétés de santé et de services financiers au sein de l'organisation Loblaw? D'une organisation à l'autre, comme de Foursquare suivi de localisation mobile vers KFC ? Dans les deux scénarios, la réponse est probablement non si les gens ne lisent pas les conditions d'utilisation et les politiques de confidentialité.

Consentement significatif et « le plus gros mensonge sur Internet »

Un consentement significatif suggère que les individus prennent conscience et comprennent la manière dont les informations personnelles sont utilisées sur le moment, ainsi que les implications pour l'avenir. Développer cette compréhension peut être difficile si les développeurs d'IA refusent d'enseigner aux gens les pratiques de l'industrie, et impossible si les gens ignorent les opportunités d'engagement et d'apprentissage.

Notant une « logique extractive » au cœur de la façon dont les développeurs d'IA collectent et utilisent les données, Crawford écrit : « Il est devenu tellement normal dans l'industrie de prendre et d'utiliser tout ce qui est disponible que peu s'arrêtent pour remettre en question la politique sous-jacente » (p. 93 ).

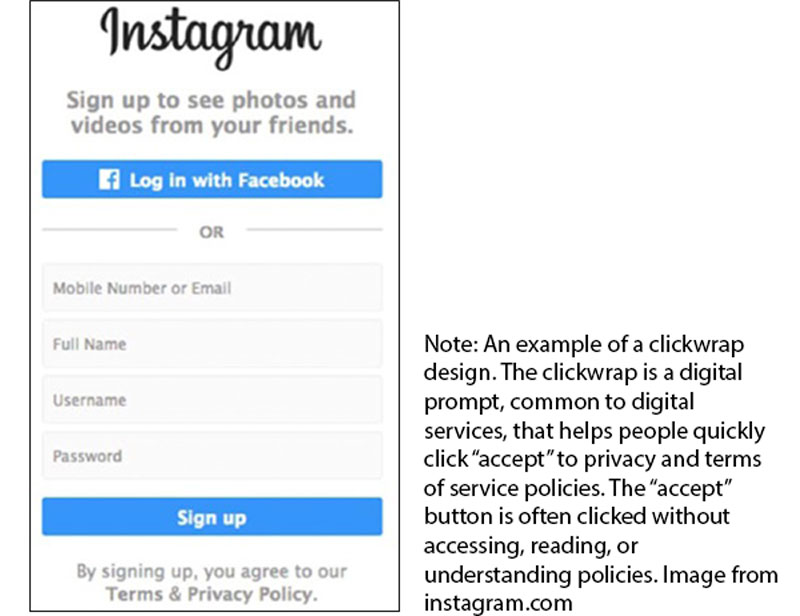

Ces politiques sous-jacentes incluent quelque chose appelé "le plus gros mensonge sur Internet" connu sous le nom de "J'accepte les termes et conditions" (voir : www.biggestlieonline.com). Ce mème Internet suggère aux gens de "mentir" en acceptant les conditions de service sans y accéder, les lire ou les comprendre. La taille (c'est-à-dire « la plus grande ») est due à l'omniprésence des services numériques, dont les termes sont acceptés en permanence.

Dans deux études tentant de déballer "le plus gros mensonge sur Internet", étudiants de premier cycle et adultes 50+ ont été présentés avec un processus de consentement en ligne fictif pour un site de médias sociaux inventé. Dans les deux études, les participants ont systématiquement ignoré et précipité le processus de consentement en ligne soit en sautant les politiques sans y accéder, soit en passant peu de temps à les lire. Pour évaluer si les participants comprenaient les implications d'un accord, les conditions de service incluaient des « clauses de piège ». Dans l'étude de premier cycle, les conditions de service comprenaient une clause «premier-né», obligeant les participants à abandonner un enfant pour utiliser le service de médias sociaux. Sur les 543 participants, 93% a accepté. Dans l'étude sur les personnes âgées, 83.4% sur 500 participants ont accepté de renoncer à un rein pour utiliser un service de médias sociaux similaire. Dans les deux études, lorsqu'on leur a demandé s'il y avait quelque chose d'inquiétant au sujet des politiques, plus de 98% des participants, dans les deux études, n'ont pas identifié ces clauses problématiques.

Si les personnes impliquées dans les deux études pouvaient manquer les clauses du piège et ne pas identifier deux implications très extrêmes du soi-disant accord, il est probable qu'elles pourraient également manquer des opportunités d'en savoir plus sur le partage de données pour le développement de l'IA.

Il y a de nombreuses raisons pour "le plus grand mensonge sur Internet", y compris le longueur et complexité des politiques de services numériques, ainsi que démission et désintéressement de l'individu. Le clickwrap (voir ci-dessus), la porte d'entrée des écosystèmes numériques façonnés et exploités par les capitalistes de la surveillance et d'autres bénéficiaires de l'IA, est particulièrement préoccupant. Au lieu d'innovations de conception pour soutenir la sensibilisation et la compréhension, cette conception trompeuse de l'interface utilisateur encourage les comportements d'ignorance - accélérant les gens à travers les processus de consentement en ligne et vers les parties des services numériques qui génèrent des revenus.

Recommandations

Le gouvernement canadien semble maintenir la position selon laquelle un consentement valable est essentiel à la protection des renseignements personnels. Le consentement est au cœur de la loi actuelle sur la protection des renseignements personnels et semble au cœur du projet de loi C-27. Mais il existe une différence considérable entre le consentement tacite ou exprès et le consentement valable. S'appuyer sur le consentement implicite facilite le manque d'autorégulation organisationnelle, ce qui rend difficile pour les gens de prendre conscience des implications de l'accord, car il y a un manque de notification que l'acceptation de la politique se produit. Le consentement exprès, qui se manifeste souvent par des accords de clic, est également problématique, car la recherche suggère (voir la vidéo ci-dessus) que les clics encouragent les comportements ignorant les termes de service au profit des développeurs d'IA.

Le seul moyen éthique d'avancer est un consentement significatif.

Que les données pour le développement de l'IA soient obtenues directement auprès d'individus ou d'une autre organisation, tous les efforts liés à la construction de l'IA doivent s'engager à garantir que les informations ont été obtenues via un consentement significatif. Les organisations doivent améliorer les processus de consentement en ligne en résolvant les accords de clickwrap problématiques. Ils doivent investir dans des stratégies réfléchies et engageantes pour informer et éduquer le public sur le développement de l'IA. Cela aidera les gens à comprendre les implications d'un accord et à réduire "le plus gros mensonge sur Internet". Sans ces efforts, un avenir défini par l'intelligence artificielle réalisée grâce à un manque de surveillance publique pourrait offrir des avantages aux développeurs et aux investisseurs, au détriment de la surveillance individuelle et des libertés civiles.

Pour plus d'informations, s'il vous plaît visitez www.biggestlieonline.com. Financé par le Commissariat à la protection de la vie privée du Canada, le Conseil de recherches en sciences humaines et l'Université York.

À propos de l’association canadienne sur les libertés civiles

L’ACLC est un organisme indépendant à but non lucratif qui compte des sympathisant.e.s dans tout le pays. Fondé en 1964, c’est un organisme qui œuvre à l’échelle du Canada à la protection des droits et des libertés civiles de toute sa population.

Pour les médias

Pour d'autres commentaires, veuillez nous contacter à media@ccla.org.

Pour les mises à jour en direct

Veuillez continuer à vous référer à cette page et à nos plateformes de médias sociaux. On est dessus Instagram, Facebook, Twitter et Ciel bleu.